Resumo: Nos próximos anos, a humanidade poderá ultrapassar irreversivelmente um limiar ao criar inteligência artificial sobre-humana de uso geral. Isto apresentaria muitos riscos sem precedentes e provavelmente seria incontrolável de várias maneiras. Podemos optar por não fazê-lo, começando por instituir limites rígidos na computação que pode ser usada para treinar e operar redes neurais. Com estes limites em vigor, a investigação e a indústria da IA podem trabalhar para tornar a IA que os humanos possam compreender e controlar, e da qual possamos colher enormes benefícios.

Introdução

Nos últimos dez anos começou algo que é único na história da nossa espécie, cujas consequências determinarão em grande parte o futuro da humanidade. A partir de 2015, os investigadores tiveram sucesso no desenvolvimento de inteligência artificial (IA) estreita – sistemas que podem vencer em Go, jogar jogos de computador, reconhecer imagens e fala, e assim por diante, melhor do que qualquer ser humano. O campo teve sucesso ao máximo. grau que, se for possível especificar com precisão uma tarefa, por exemplo, criando uma métrica calculável de sucesso, um sistema de máquina provavelmente poderá ser treinado para realizar essa tarefa, geralmente melhor do que as pessoas. Isto é um sucesso incrível e está a produzir sistemas e produtos extremamente úteis que irão capacitar a humanidade. Mas a estreita inteligência artificial nunca foi o verdadeiro objectivo deste campo. Em vez disso, o objetivo tem sido criar sistemas de IA de uso geral, especialmente aqueles que sejam simultaneamente tão bons ou melhores que os humanos em quase todas as tarefas, assim como a IA é agora sobre-humana em Go, xadrez, pôquer, corridas de drones, etc. chamada de “inteligência artificial geral” e aqui a chamaremos de “IA de propósito geral sobre-humana” (SGPAI).2 Este é o objetivo declarado de uma série de esforços, incluindo os de várias grandes empresas.3 Também aqui estes esforços estão a ter sucesso. Sistemas de IA de uso geral como GPT-4, Palm-2 e Claude-2, baseados em cálculos massivos e montanhas de dados, alcançaram a paridade com humanos típicos em uma ampla variedade de tarefas. Agora, os engenheiros de IA de algumas das maiores empresas de tecnologia estão correndo para levar esses experimentos gigantescos em inteligência de máquina para o próximo nível.4 Não deveríamos fazer isso. Agora não, talvez nunca. Por que? Porque logo após esses sistemas de inteligência de máquina competirem com a inteligência humana, é provável que percamos progressivamente o controlo sobre eles.

Como disse Alan Turing há 72 anos, “uma vez que o método de pensamento da máquina tivesse começado, não demoraria muito para superar nossos fracos poderes. uns aos outros para aguçarem a sua inteligência. Em algum momento, portanto, devemos esperar que as máquinas assumam o controle…

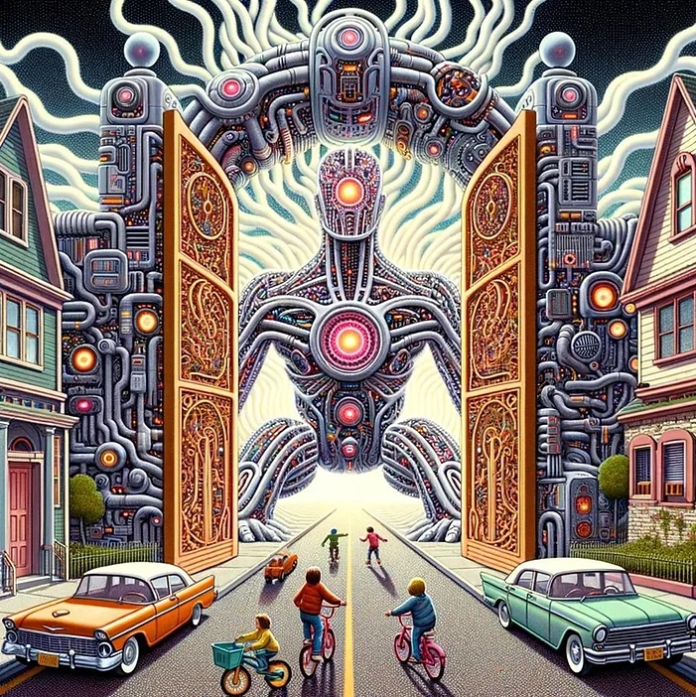

Este ensaio é um argumento extenso sobre por que não deveríamos, nos próximos anos, abrir irrevogavelmente esta porta: não deveríamos treinar neurônios em redes melhores do que quase todos humanos em uma ampla gama de tarefas intelectuais, e muito menos melhores do que os melhores especialistas humanos ou mesmo de toda a civilização humana. Em vez disso, deveríamos estabelecer um limite rígido e indefinido para a computação total empregada no treinamento de uma rede neural completa individual, um limite para a velocidade de execução de tal rede neural e provavelmente outros limites.

Embora não construir máquinas mais inteligentes do que nós, provavelmente pareça uma ideia bastante sensata para a maioria das pessoas, é uma posição rara na comunidade da IA e mesmo nas discussões políticas sobre IA, onde o avanço inexorável da capacidade da IA é muitas vezes tido como um dado adquirido.

Mas há muitas tecnologias que a humanidade poderia ter seguido, mas que optou por não desenvolver ou optou por deixar de avançar: exemplos incluem a clonagem humana, a engenharia da linha germinativa humana, a eugenia, as armas biológicas avançadas e outras.

O argumento de que deveríamos obter escolha semelhante com sistemas de IA “fora do portão”, ou seja, que ultrapassam significativamente a capacidade dos sistemas fronteiriços atuais, é a seguinte:

1. Estamos no limiar da criação de especialistas competitivos e sub-sistemas GPAI perhumanos em um tempo que pode ser tão curto quanto alguns anos.

2. Esses sistemas fora do Portão representam riscos profundos para os seres humanose para sociedade, que vão desde, no mínimo, uma enorme perturbação da sociedade até, no máximo, a desempoderação humana permanente ou a extinção.

3. A IA tem enormes benefícios potenciais. No entanto, a humanidade pode colher quase todos os benefícios que realmente desejamos da IA com sistemas dentro do Portão, e podemos fazê-lo de maneira mais segura e com arquiteturas transparentes a todos.

4. Muitos dos supostos benefícios do SGPAI também são de dois gumes tecnologias com grande risco. Se existem benefícios que só podem ser realizados com sistemas sobre-humanos, podemos sempre escolher, como espécie, desenvolvê-los mais tarde, uma vez que os julguemos suficientes – e de preferência comprovadamente – seguro. Depois de desenvolvê-los, é muito improvável que haja algum retrocesso

5. Os sistemas dentro do Portão continuarão a ser muito perturbadores e a representar uma grande variedade de riscos – mas estes riscos são potencialmente geríveis com uma boa governança.

6. Finalmente, não só devemos como podemos implementar um “fechamento de portão”: embora o esforço necessário e a coordenação global sejam difíceis, existem dinâmicas e soluções técnicas que tornam isso muito mais viável do que pode parecer.

As seções a seguir desenvolvem esses seis pontos em detalhes.

No limiar

Sabemos agora quanta computação é suficiente para criar uma rede neural digital que pode igualar ou exceder o desempenho humano típico numa gama significativa de tarefas intelectuais, incluindo raciocínio e resolução de problemas. São cerca de cem trilhões, ou 1.025, operações de ponto flutuante (FLOP). Este é o nível estimado de computação empregado no treinamento do GPT-4 da OpenAI e redes neurais de aprendizagem profunda comparáveis.

Essas redes neurais são capazes de ter um bom desempenho em uma ampla gama de testes de inteligência baseados em texto que incluem matemática, senso comum raciocínio, diversas disciplinas científicas e redação de códigos. Isto inclui testes, como o esquema Winograd, que foram especificamente concebidos para testar a inteligência geral e a nível humano. Há muitas coisas que essas redes neurais não podem fazer. Atualmente a maioria é desencorpada – existindo apenas em servidores – e processa no máximo texto e imagens estáticas. Até agora, ninguém consegue, por si só, realizar uma manipulação simbólica cuidadosa e confiável ou um raciocínio formal através de muitas etapas (embora seja certo que a maioria das pessoas também não o consegue). E os sistemas atuais não conseguem superar os melhores especialistas humanos nas tarefas em que são peritos.

Pode-se debater se estes sistemas “pensam” ou “compreendem” ou “razão” nos sentidos que os humanos fazem; provavelmente não. Mas como quer que chamemos, eles fazem isso tão bem quanto muitas pessoas, em tarefas que vão desde escrever poesia até revisar códigos. A IA de propósito geral competitiva entre humanos está aqui. E com técnicas conhecidas são necessários cerca de 1.025 FLOP, juntamente com um conjunto de dados de treinamento apropriado, para criar do zero. Usando o prefixo científico “yotta” para representar 1.024, podemos dizer que são necessários cerca de 10 yottaFLOP.

O valor é muito importante: pode significar o limiar entre a capacidade competitiva humana e a capacidade sobre-humana.

Também sabemos (aproximadamente) quanto de velocidade de computação, em operações por segundo, é suficiente para que tal sistema corresponda à velocidade do processamento de texto humano. É cerca de 1015 − 1016 FLOP por segundo.

Novamente usando prefixos científicos, isso é 1-10 petaFLOP/s.

O que acontece se aumentarmos esses números de 10 yottaFLOP e 10 petaFLOP/s ou tornar os algoritmos mais eficientes? Bem, os sistemas de IA se tornarão mais rápidos e/ou “mais inteligentes”, ou seja, mais competitivos.

Que o hardware mais rápido permite maior velocidade de execução da IA é bastante claro.

Quanto aos “mais inteligentes”, maiores quantidades de computação de treinamento produziram aumentos confiáveis na eficácia da IA na métrica de treinamento. Surpreendentemente, métricas de treinamento simples (como a previsão de palavras) traduziram-se emergentemente em competência em áreas relacionadas e aparentemente… tarefas não relacionadas (ou seja, todos os tipos de processamento de texto). Portanto, é quase certo que modelos maiores com mais computação de treinamento terão capacidades novas e melhores, mesmo que seja difícil prever quais serão; e até agora esses avanços têm sido bastante significativos quando uma computação significativamente maior é empregada.

Além disso, as limitações dos modelos GPAI atuais, como o GPT-4, podem ser remediado por outras técnicas conhecidas em IA. Já existem sistemas de IA que podem captar e processar dados sensoriais, como sons e imagens, que podem gerar novas mídias, que podem resolver quebra-cabeças de forma incorporada em ambientes (simulados) e que podem planejar e perseguir objetivos.Não surgiram grandes obstáculos. na combinação destas capacidades (nem na combinação de diferentes modalidades de formação) e não há razão para pensar que a capacidade humana nessas capacidades seja qualquer tipo de barreira que não possa ser ultrapassada. Os investigadores também estão aprendendendo como construir “andaimes” de software em torno de sistemas de IA e fornecer-lhes ferramentas para os fazer funcionar significativamente melhor e integrá-los entre si.

Os pesquisadores não têm nenhuma ideia real de como incorporar qualidades humanas, como consciência fenomenal, senciência e emoção em sistemas de IA. Em princípio, é possível que isto seja a chave para desbloquear totalmente a cognição a nível humano, mas até agora não foi necessário ter qualquer consideração sobre estes aspectos na construção de sistemas de IA que possam executar uma extensa variedade de tarefas a um ritmo muito lento.

Portanto, com técnicas conhecidas, computação suficiente e permitir talvez algoritmos melhores, é quase certo que podemos treinar sistemas de IA que sejam melhores do que os humanos típicos em uma ampla variedade de tarefas, é muito provável que sejam melhores do que os especialistas humanos em algum subconjunto deles (GPAI competitivo de especialistas), e muito provavelmente que logo depois disso sejam sistemas que são geralmente sobre-humanos (SGPAI).

Exatamente a que distância cada um deles está? Nós simplesmente não sabemos.

A computação usada na maior execução de treinamento de IA aumentou 100 milhões de vezes nos últimos dez anos, elevando-a para cerca de 10 yottaFLOP. A diferença de capacidade entre IAs treinadas com 1 e 10 yottaFLOP parece ser significativa. No mundo biológico, uma diferença de 10 vezes na contagem de neurônios é a diferença entre ursos e humanos; e uma diferença de treinamento de 10x poderia ser aquela entre um período de 3 anos.

Enquanto isso, as técnicas de andaimes e ferramentas estão melhorando muito rapidamente.

Dada a capacidade dos atuais sistemas 10 yottaFLOP, se cruzarmos através deste Portal, podemos prever com segurança que os sistemas de IA serão inicialmente como os de agora, mas muito melhores. Depois disso, em breve começaremos a entrar na terra incógnita em termos de sistemas inteligentes e dos riscos que podem representar para a humanidade.

Sistemas fora do Portal são profundamente arriscados para a humanidade

Existem muitos riscos de sistemas fora do Portão. Aqui estão dez exemplos.

• Eles automatizarão rapidamente muitas tarefas; isso pode interromper o trabalho, levando a uma desigualdade de rendimentos dramaticamente maior e ao subemprego ou desemprego em grande escala, numa escala de tempo demasiada curta para a sociedade se ajustar.

• Eles podem aumentar drasticamente a capacidade de terroristas, malfeitores e estados desonestos causarem danos por meio de ações biológicas, químicas, cibernéticas, armas autônomas ou outras, sem que a IA forneça um contra-ataque para equilibrar a capacidade de prevenir tais danos.

• Provavelmente levariam à concentração de vastos recursos económicos, poder social e político – potencialmente mais do que o dos Estados-nação – num pequeno número de enormes interesses privados inacessíveis. contável ao público.

• Poderiam permitir vigilância e manipulação em massa eficazes sistemas utilizáveis por governos ou interesses privados para controlar uma população e prosseguir objetivos em conflito com o interesse público.

• Eles poderiam ser, ou criar, softwares inteligentes avançados e auto-replicantes. vírus e worms que podem proliferar e até mesmo potencializar e evoluir, perturbando massivamente os sistemas de informação globais.

• Eles poderiam inundar a coleta, o processamento e o processamento de informações da sociedade.

sistemas de comunicação com informações falsas, com spam ou excessivamente direcionadas, ou mídia manipuladora tão completa que geralmente se torna quase impossível dizer o que é fisicamente real ou não, humano ou não, factual ou não, e confiável ou não.

• Ao minar o discurso humano, o debate e os sistemas eleitorais, poderiam reduzir a credibilidade das instituições democráticas ao ponto de serem efectivamente (ou explicitamente) substituídas por outras, acabando com a democracia nos atuais estados democráticos.

• Poderiam levar a um hipercapitalismo descontrolado e rápido em grande escala, com empresas efetivamente geridas por IA competindo num mercado predominantemente eletrónico.

Todos os modos de falha e externalidades negativas das atuais economias capitalistas poderiam ser exacerbada e acelerada muito além do controle humano, da governança ou capacidade regulatória.

• Eles poderiam alimentar/alimentar uma corrida armamentista entre nações em IA armamento motorizado, sistemas de comando e controle, armas cibernéticas, etc., levando a um acúmulo muito rápido de capacidades extremamente destrutivas. habilidades.

• Eles poderiam efetivamente acabar com a cultura humana quando quase todas as culturas objetos (texto, música, artes visuais, filmes, etc.) consumidos pela maioria das pessoas são criados, mediados ou curados por mentes não humanas.

Algumas delas são apresentadas ou realizadas de forma nascente nos sistemas de IA atuais, mas, conforme discutido abaixo, podem ser administráveis se a capacidade da IA permanecer dentro dos limites. Mas quanto mais fora do Gate AI for desenvolvido, mais intratáveis eles serão. Nenhum é inevitavelmente desastronômico, mas também nenhum deles é algo com o qual a sociedade parece remotamente preparada para lidar em uma escala de tempo de anos.

Vamos nos concentrar em um risco adicional que é global e generalizado, porque não é um acidente ou um efeito colateral, mas sim o destino natural e quase inevitável do desenvolvimento irrestrito da IA.

Isto é que nós (como espécie) estamos atualmente em um processo próximo do fim, cujo ponto é uma ou mais IAs de uso geral altamente sobre-humanas.

Sistemas como este quase certamente não são controláveis por organizações e instituições humanas. Portanto, estamos atualmente em um processo, cujo ponto final é a alta probabilidade de perda global de controle da humanidade pela IA. Quando perdermos o controle, as coisas poderão correr bem ou muito mal para a humanidade. Ninguém sabe realmente e não dependerá de nós.

Esta é uma afirmação forte, então vamos examinar esse argumento com mais detalhes.

Estamos atualmente em um processo cujo ponto final é um ou mias sistemas de IA de uso geral mais altamente sobre-humano, ou seja, sistemas de IA em grupos que são mais capazes em quase todas as tarefas intelectuais do que especialistas humanos ou mesmo instituições humanas inteiras – por ex. mais capaz em fazer física teórica do que a comunidade humana de físicos teóricos e suas instituições.

O processo em que nos encontramos é o desenvolvimento competitivo de sistemas de IA de uso geral mais capazes, utilizando capacidades e recursos gerados por uma geração de capacidade de IA para construir a próxima. É claro que as maiores empresas de tecnologia do mundo estão correndo para tentar construir sistemas de IA de uso geral cada vez mais capazes, e o objetivo explícito de pelo menos vários deles é a “inteligência artificial geral” ou a “superinteligência”. Mas o que é importante não é apenas que eles estejam tentando, mas que estejam conseguindo e como.

Tanto em sistemas demonstrados como em produtos implantados – traz investimento, talento e concorrência adicionais. Isso seria verdade para qualquer tecnologia desenvolvida com sucesso e é muito importante. O desenvolvimento da IA vai mais longe, na medida em que os sistemas de IA podem ajudar a desenvolver sistemas novos e melhores.

Entendam! Isso já está acontecendo, com amplo suporte de codificação de IA para humanos,design de chips habilitados para IA,melhoria de algoritmos relevantes para o treinamento de IA,e sistemas de IA treinando outros sistemas de IA.

Atualmente, o “ciclo de melhoria” de uma geração de sistemas de IA para a seguinte é maioritariamente conduzida por seres humanos.Mas com cada melhoria sucessiva, os sistemas de IA podem assumir mais tarefas humanas e realizá-las melhor e/ou mais rapidamente.

Quer a própria IA, quer apenas a capacidade mental, fiscal e corporal humana.

A taxa/recursos institucionais que ela desbloqueia revelam-se mais relevantes, a chave é que existe um ciclo de feedback positivo sobre a capacidade geral da IA. Não existem condições de amortecimento significativas: os recursos são abundantes, o talento é limitado mas esta sendo produzido, novas instituições estão a ser recompensadas e o processo regulamentar é atualmente quase nulo. E há uma pressão financeira e competitiva muito forte que impulsiona as empresas.

Portanto, nossa expectativa deve ser uma progressão contínua de capacidades até que a paridade com especialistas humanos seja alcançada.

Uma vez que exista um sistema que possa funcionar amplamente em termos de especialistas humanos, é muito provável que seja um pequeno passo para uma IA de propósito geral altamente sobre-humana. No mínimo, simplesmente executar muitos sistemas altamente capazes em paralelo e em alta velocidade, que são capazes de comunicar e partilhar a compreensão com muito mais eficiência do que os humanos , provavelmente constituiria um SGPAI altamente. De modo mais geral, o mesmo ciclo de feedback auto-reforçador que levou aos sistemas de nível especializado provavelmente continuaria a partir daí. Não existem limites teóricos estabelecidos para a capacidade de tal sistema além de alguns propostos com base na complexidade do mundo e aqueles impostos à computação pela física, ambos os quais excedem as limitações humanas em ordens de grandeza.

Os primeiros SGPAI podem ou não fazer tudo tão bem como algumas pessoas muito treinadas e talentosas. Mas eles fariam muitas coisas muito melhor, tal como os sistemas de xadrez ou de jogo fazem agora, e muito mais rapidamente, tal como os atuais modelos de linguagem compõem texto de qualidade muito mais rapidamente do que qualquer ser humano. E previsivelmente teriam habilidades que nenhum ser humano tem, como acesso direto e instantâneo a sistemas formais e simulações para planejamento e engenharia, capacidade de ler e escrever códigos complexos quase instantaneamente, um potencial muito maior de memória de trabalho e apreensão direta de muito mais conhecimento e compreensão. E isso é apenas o começo.

Um sistema GPAI sobre-humano não é controlável por sistemas humanos. regras e instituições.

Perda de controle de GPAIs sobre-humanos – seja súbita ou gradual – é altamente provável em quatro sentidos.

Primeiro, para que possamos manter o controle dos sistemas de IA, eles devem ser constituídos instruídos para fazer o que queremos que eles façam. Isso parece simples, mas esconde um nível incrível de dificuldade com sistemas avançados.

Para fazer o que queremos, os sistemas de IA terão de (a) ser competentes na realização das tarefas solicitadas; (b) “entender” o que “nós” queremos; (c) realmente fazê-lo. A dificuldade das partes (b) e (c) é o que muitas vezes é chamado de “problema de alinhamento”. Também podemos pensar nisso em termos de lealdade: o sistema de IA deveria ser leal a um sistema humano, adotando os objetivos do humano como seu próprio. A verdade importante e infeliz é que não sabemos como construir sistemas de IA poderosos e leais. Isso é mais ou menos universalmente acordado entre os pesquisadores que estudam o problema.

Por que não?

Parte (b) – “entender” o que “nós” queremos é muito difícil. Mesmo considerando os seres humanos individuais, muitas vezes não entendemos o que os outros querem, ou mesmo o que nós mesmos queremos; pode ser extremamente sutil e até mal definido. E se “nós” somos muitos humanos com desejos conflitantes, o que é que “nós” queremos?

Mas a parte (c) é ainda mais difícil: como podemos garantir que um sistema de IA “se preocupará” com o que queremos? Podemos treinar sistemas de IA para dizer e não dizer coisas, fornecendo feedback; e eles podem aprender sobre o que os humanos querem e se preocupam, assim como raciocinam sobre outras coisas. Mas, mesmo em teoria, não temos nenhum método para fazer com que eles “se preocupem” com segurança com o que as pessoas se preocupam. Existem psicopatas humanos de alto desempenho que sabem o que é certo e o que é errado e como devem se comportar. Eles simplesmente não se importam. Mas eles podem agir como se o fizessem, se isso fosse adequado ao seu propósito. Assim como não sabemos como transformar um psicopata (ou qualquer outra pessoa) em alguém genuinamente e completamente leal, não temos ideia de como resolver o problema de alinhamento em sistemas avançados o suficiente para se modelarem como agentes no mundo, e potencialmente enganar.

Se a situação se revelar inatingível ou impossível, os SGPAI não estarão sob controle.

Segunda razão para esperar a perda de controle. Suponhamos agora que de alguma forma o alinhamento seja bem-sucedido, no sentido geral de “fazer coisas que são boas para os humanos” e “não fazer coisas que prejudiquem os humanos”. Isso ainda não significará controle humano, uma vez que quase certamente exigiria a desobediência às diretrizes humanas para fazer coisas prejudiciais. Ou seja, mesmo que tivéssemos domínio completo sobre o design do sistema de IA, existe a questão fundamental de que não podemos ter obediência total ao mesmo tempo.

Como exigir da IA obidiência e benevolência total sendo que os humanos não são totalmente benevolentes!

Oos modelos de linguagem irão, por definição, recusar-se a cumprir certas solicitações, como a criação de conteúdo tóxico ou perigoso. Mas agora extrapolemos: ou um dado GPAI sobre-humano será absolutamente obediente e leal a algum sistema de comando humano, ou não será. Caso contrário, fará coisas que acredita serem boas para nós, mas ao contrário aos nossos desejos. Isso não é algo que esteja sob controle.

Terceiro, e novamente assumindo que a lealdade está “resolvida”, os humanos são muito propensos a delegar o controle a um sistema de máquina altamente eficaz, inclusive ao ponto em que esse controle não pode ser retomado facilmente.

ovamente já vemos isso. As pessoas delegam o seu próprio trabalho a sistemas de IA, quer porque é mais rentável, mais rápido ou, na verdade, melhor, ou simplesmente porque são preguiçosas. Além disso, num ambiente competitivo, sentem que têm de o fazer. Atualmente, tais delegações são facilmente revertidas. Mas o objetivo da criação de uma GPAI sobre-humana é que ela pode fazer coisas que os humanos não podem, incluindo planejar, avaliar e tomar decisões (tudo isso faz parte da consecução de qualquer objetivo complexo). estratégia de desenvolvimento, etc., são entregues a um sistema cujo raciocínio completo não é replicável ou talvez mesmo compreensível pelos seres humanos, cuja transferência será muito, muito difícil de resolver, mesmo que as pressões competitivas sejam desconsideradas.

Finalmente, suponha que um sistema GPAI sobre-humano seja, de alguma forma, feito de ambos perfeitamente leais/subservientes e um delegado perfeito para algum operador. Isto é, ele entende perfeitamente e faz o que seus operadores querem e pretendem, ao mesmo tempo que os deixa significativamente no controle.

E suponhamos ainda que exista apenas um, significativamente mais avançado que os concorrentes, para que não haja pressão competitiva e deixar as suas capacidades esgotarem-se ainda mais ou para delegar demasiadamente. Esta é a situação dos sonhos para o desenvolvedor e operador de IA.

Mas o que pensam disto as outras estruturas de poder do mundo?

O que o governo chinês pensa quando os EUA conseguirem (ou parecem estar conseguindo) isso?

Ou vice-versa?

O que o governo dos EUA (ou chinês, ou russo) pensa quando OpenAI, Deepmind ou Anthropic têm (ou parecem estar conseguindo) isso?

O que pensa o público em geral dos EUA se acreditar que a Microsoft, a Meta ou uma empresa chinesa tem (ou parece estar a obter) isto?

O que eles vão pensar corretamente é que isto é uma ameaça existencial à sua existência como estrutura de poder – e talvez até ao seu período de existência (dado que eles podem não ter certeza de que o sistema está de fato sob controle.

Todos esses agentes muito poderosos – incluindo governos de nações totalmente equipados que certamente têm os meios para fazê-lo – estariam altamente motivados para obter ou destruir tal capacidade, seja por força ou subterfúgio.

Que país poderia ser encarregado de abrigar uma IA com essa capacidade sem convidar alguém a um ataque imediato.

E depois de todos esses ataques:

1. O mundo está como uma ruína fumegante, ou

2. O SGPAI obediente proliferou para vários atores mutuamente hostis, ou eles estão de volta à competição para conseguir um, ou um grupo, enquanto, com a ajuda de seu SGPAI, assume o controle dos outros.

O problema fundamental é que não existe uma situação estável onde existe concorrência entre países, empresas, etc e controle humano – a competição leva inevitavelmente à delegação do controle. E eliminar a competição da IA exige que um conjunto de humanos tome o poder (o que parece extremamente improvável de ter sucesso em vez de levar à guerra), ou que os grupos humanos voltem a criar involuntariamente um nexo de poder partilhado, estável e de longo prazo para “manter” o SGPAI e impedir que outros concorram com ele.

Esse nexo não existe ou parece estar no horizonte.

Portanto, estamos atualmente num processo cujo ponto final é a alta probabilidade de perda global de controle da IA pela humanidade.

A IA fez com que tudo ficasse fora de controle.Existe também uma probabilidade significativa de perda de controle para a IA ou para um único interesse privado que controla essa IA. Notaremos, embora seja bastante óbvio, que a perda de controle da humanidade para a IA também implica a perda de controle dos Estados Unidos por parte do governo dos Estados Unidos; significa a perda de controle da China pelo Partido Comunista Chinês e a perda de todos os outros países pelo seu próprio governo. Assim, as empresas de IA são, mesmo que esta não seja a sua intenção, atualmente participantes na potencial derrubada de governos mundiais, incluindo o seu próprio. Isto poderá acontecer numa questão de anos.

Deveria ser evidente que: se perdermos o controle para a IA, as coisas podem correr bem para a humanidade, ou muito mal. Ninguém realmente sabe, e isso e não dependerá de nós. Teremos substituído a nós mesmos como a espécie dominante na Terra, que tem agência sobre o seu próprio destino e o dos outros.

Isto, juntamente com o enfrentamento da pilha de outros riscos de grande escala listados acima, é o que acontece se não pararmos em algum lugar. Mas por que parar aqui?

Por que o atual nível de avanço, no nível yottaFLOP e petaFLOP/s, é crucial?

Se a humanidade quiser manter o controle do seu futuro, não saber até onde podemos deixar a IA avançar antes que a perda de controle comece e seja imparável. Pode ser que a próxima geração de IA seja o verdadeiro limiar, ou a seguinte. O que sabemos é que o processo descontrolado em curso só se tornará mais difícil de inter-relacionar.

Sabemos também que, uma vez implantado um sistema, e especialmente quando esse nível de capacidade do sistema prolifera, é extremamente difícil revertê-lo. Da mesma forma, se um sistema for desenvolvido (especialmente com grandes custos e esforços), haverá uma enorme pressão para utilizá-lo ou implementá-lo, e a tentação de que seja vazado ou roubado. Isto quer dizer que simplesmente desenvolver sistemas e depois decidir se são profundamente inseguros é um caminho perigoso.Sem uma forma de compreender e prever as capacidades dos novos sistemas de IA, cada aumento sucessivo da sua capacidade é a abertura de uma incógnita. abrir a caixa de Pandora cada vez gera mais riscos.

Podemos colher os benefícios da IA sem abrir o portão.

A inteligência, seja biológica ou mecânica, pode ser amplamente considerada a capacidade de criar futuros mais alinhados com algum conjunto de objetivos. Como tal, a inteligência traz enormes benefícios quando usada na busca de objetivos escolhidos com sabedoria. A inteligência artificial está a atrair enormes investimentos de tempo e esforço, em grande parte devido aos benefícios prometidos. Portanto, deveríamos perguntar: até que ponto ainda obteríamos os benefícios da IA se contivessemos o seu progresso desenfreado? Mais precisamente, podemos perguntar: até que ponto “fechar o portão”, através da imposição de limites computacionais, realmente restringiria o que realmente queremos fazer com a IA num futuro próximo? Pode ser surpreendentemente pouco, e com o benefício adicional de tornar os nossos sistemas de IA muito mais compreensíveis e melhor integrados na sociedade humana.

Consideremos primeiro que os sistemas da geração GPT-4 já são muito poderosos, e nós apenas arranhamos a superfície do que pode ser feito com eles. Eles são claramente capazes de “comandar o show” em termos de “compreender” uma questão ou tarefa apresentada a eles e o que seria necessário para responder a essa pergunta ou realizar essa tarefa. Melhorias algorítmicas, novos regimes de treinamento, avanços na elaboração imediata e melhor curadoria de conjuntos de dados poderiam quase certamente torná-los consideravelmente mais capazes no mesmo nível de computação de treinamento.

Em seguida, grande parte do entusiasmo em relação aos sistemas modernos de IA se deve a sua generalidade; mas alguns dos sistemas de IA mais capazes – como os que geram ou reconhecem fala ou imagens, fazem previsões e modelos científicos, jogam jogos, etc. – são muito mais restritos e estão bem “dentro do Portão” em termos de computação. Esses sistemas são sobre-humanos nas tarefas específicas que realizam. Podem ter fraquezas extremas (ou exploráveis) devido à sua estreiteza; por mais restritos ou totalmente gerais que sejam, não são as únicas opções disponíveis: dado um orçamento de computação, provavelmente veríamos modelos GPAI pré-treinados com (digamos) metade desse orçamento, e a outra metade usada para treinar capacidades muito elevadas numa gama mais restrita de tarefas. Isto daria uma capacidade estreita sobre-humana apoiada por uma inteligência geral quase humana.

Agora, esses sistemas de vários níveis de generalidade podem ser combinados em sistemas compostos. Os GPAIs atuais são perfeitamente capazes de usar as ferramentas que lhes são apresentadas, e isso pode incluir outros sistemas de IA de generalidade variada.Também temos visto “wrappers” cada vez mais sofisticados que geram automaticamente prompts, depois processam a saída e geram novos prompts.

O que é crucial notar é que a comunicação entre estes elementos de um sistema composto podem ser legíveis por humanos.Ou seja, em vez de um poderoso sistema de IA ser uma caixa preta gigante e inescrutável, ele pode ser um amálgama de múltiplos componentes, cada um dos quais tem uma função compreensível, e onde os humanos (ou sistemas de IA) podem auditar como e por que cada um está sendo chamado. Alguns desses componentes podem ser caixas pretas, e outros podem ser claramente interpretáveis (por exemplo, se forem simplesmente códigos). Mas a ideia seria que nenhuma das caixas pretas seria ao mesmo tempo muito geral e super-humanamente capaz – apenas o composto poderia ser ambos. Da mesma forma, em termos de velocidade, muitos componentes (como a maioria dos programas modernos) podem ser extremamente rápidos. Mas se for implementado um limite de velocidade de corrida, as peças mais poderosas e gerais não ultrapassariam dramaticamente os humanos. Isto é crucial, porque os seres humanos não conseguem permanecer significativamente informados num sistema que funciona dramaticamente mais rápido do que um ser humano.

É claro que tais sistemas compostos se assemelham muito ao que os humanos fazem para criar mais capacidade: operamos juntos em grupos. Isto tem desvantagens significativas, mas foi o que nos permitiu criar tecnologia, civilização e tudo o mais de interesse que fizemos.

Os sistemas de IA podem e provavelmente irão operar também em grupos e coletivos; a questão será se estaremos envolvidos de forma significativa ou se permitiremos que esses sistemas se tornem suficientemente poderosos para que isso não seja possível.

Esta ideia de IA mais interpretável e segura através da modularidade foi desenvolvido com algum detalhe; veja, por exemplo o modelo de “Serviços Abrangentes de IA” desenvolvido por Drexler, a “Arquitetura de Agência Aberta” de Dalrymple e o modelo de “Emulação Cognitiva” de Leahy & Alfours. Todos esses autores veem as arquiteturas propostas como tendo propriedades muito melhores em termos de segurança e controle do que os agentes unitários (especialmente os de caixa preta), ao mesmo tempo que suportam um sistema agregado de IA que é “transformador” em sua capacidade. A principal “fraqueza” dessas arquiteturas é que elas podem ser mais trabalhosas para serem criadas e podem ser menos poderosas do que um sistema criado por treinamento de “força bruta” de um único agente com enormes quantidades de comandos.

É precisamente aí que o encerramento do portão ajuda, eliminando estas alternativas potencialmente inseguras ou incontroláveis.

Notavelmente, o fechamento do portão não precisa afetar negativamente as empresas que constroem hardware e software de IA. Um yottaFLOP de computação requer uma grande quantidade de hardware especializado, e definir esse limite provavelmente levaria as empresas a redirecionar recursos para tornar os sistemas no nível yottaFLOP melhores, mais diversificados e especializados, em vez de criar novos sistemas maiores.

A vantagem de avançar para a inteligência sobre-humana é modesta em relação ao risco negativo: podemos sempre optar por prosseguir mais tarde e sob melhor controle.

Por que as pessoas e as empresas estão tentando construir uma IA sobre-humana de uso geral? Quando questionadas, algumas respostas seriam que as empresas estão “apenas” a construir IA a nível humano. Isto é hipócrita: para tarefas on-line já temos IA de “nível humano”, dependendo dos humanos. As empresas estão buscando construir IA melhor do que os humanos mais experientes nas áreas em que esses especialistas são melhores; e isso dificilmente pode ajudar, mas rapidamente levará a sistemas ainda mais capazes. Outras respostas consistem muitas vezes em enumerar, de forma algo vaga, problemas em que a IA poderia ajudar: novos medicamentos, novos materiais, novos mecanismos de coordenação e, em geral, melhorar as coisas para as pessoas. (Para uma discussão mais concreta sobre a IA abordando os Objetivos de Desenvolvimento Sustentável da ONU. É razoável que estes objetivos possam ser algo vagos: muitas vezes criamos tecnologias e, mais tarde, decidimos qual a melhor forma de as utilizar. Mas é importante notar que todas as aplicações geralmente listadas são aquelas para as quais a IA in-Gate provavelmente é suficiente – ou pelo menos onde estamos muito longe de explorar o seu potencial.

Portanto, sejamos claros sobre o que está realmente motivando a busca por IA fortemente sobre-humana. Quer sejam ou não alcançáveis, são coisas como:

1. Curas para muitas ou todas as doenças;

2. Parar e reverter o envelhecimento;

3. Fontes de energia sustentáveis como fusão;

4. Atualizações humanas, ou organismos projetados por meio de engenharia genética;

5. Nanotecnologia e fabricação molecular;

6. Carregamentos mentais;

7. Física exótica ou tecnologias espaciais;

8. Aconselhamento sobre-humano e apoio à decisão;

9. Planejamento e coordenação sobre-humanos

Conforme discutido acima, muitos deles podem ser alcançados com o in-Gate sistemas (e humanos), embora provavelmente mais lentamente. Deixando isto de lado, vale a pena categorizar um pouco estas motivações para o SGPAI, como se segue.

As três primeiras são, em grande parte, tecnologias de “borda única” – ou seja, provavelmente ser fortemente positivo líquido. É difícil argumentar contra a cura de doenças ou viver muito mais tempo, se assim o desejarmos. E já colhemos o lado negativo da fusão (na forma de armas nucleares); seria ótimo também obter o lado positivo. Portanto, a questão aqui é se a obtenção destas tecnologias mais cedo compensa o risco.

Os próximos quatro são claramente de dois gumes: tecnologia transformadora tecnologias com vantagens potencialmente enormes e riscos imensos, tal como a IA. Tudo isto, se amanhã surgisse de uma caixa negra e fosse realmente implementado, seria incrivelmente difícil de gerir bem, uma vez que não temos regras, normas ou instituições em vigor para o fazer.

Os dois últimos dizem respeito à IA sobre-humana realmente fazendo coisas em vez de apenas inventar tecnologia.

Deixando de lado os femismos, estes envolvem poderosos sistemas de IA que dizem às pessoas o que fazer. Chamar isso de “conselho” é falso se o sistema que presta o aconselhamento for muito mais poderoso do que o aconselhado, que não consegue realmente compreender a base da decisão (ou mesmo se esta for fornecida, confiar que o consultor não forneceria uma justificativa igualmente convincente para uma decisão diferente.)

A ação é uma forte capacidade humana, e somos excelentes nisso quando escolhemos ser. Existem, sem dúvida, sistemas que poderíamos (e deveríamos) conceber ou implementar para coordenar melhor, de forma mais ampla e mais inteligente. Mas não precisamos de IA sobre-humana para isso; a maneira pela qual seria capaz de fazer isso acontecer seria através da persuasão sobre-humana, da política ou da força.

Isso aponta para um membro importante deixado de fora da lista acima:

10. Poder

É bastante claro que muito do que está subjacente à atual corrida pela IA sobre-humana é a ideia de que inteligência = poder. Cada piloto aposta em ser o melhor detentor desse poder e em ser capaz de exercê-lo por razões ostensivamente benevolentes, sem que ele saia ou seja tirado de seu controle.

O fato de eles quererem o poder não significa que o resto de nós deva permitir.

Mesmo supondo que haja alguma enorme vantagem no super-humano GPAI que não pode ser obtido pela humanidade usando GPAI in-Gate, em pesando os riscos e as recompensas, existe uma enorme assimetria entre esperar e correr: podemos esperar até que isso possa ser feito de forma segura e benéfica (de preferência comprovável, e quase todos ainda poderão colher os frutos; se nos apressarmos, pode ser – nas palavras do CEO da OpenAI – que as luzes se apaguem.

Os riscos dos sistemas dentro do Gate são, em princípio, administráveis.

Mas não será fácil. Os atuais sistemas de IA de ponta são bastante poderosos e podem capacitar significativamente as pessoas e instituições para alcançarem os seus objetivos. Isso é, em geral, uma coisa boa! No entanto, há uma dinâmica natural de ter tais sistemas à nossa disposição

– repentinamente e sem muito tempo para a sociedade se adaptar – que oferecem riscos graves que precisam de ser geridos. Vale a pena discutir algumas classes principais de tais riscos, e como podem ser diminuídos, assumindo um fecho de porta.

Uma classe de riscos é a de os GPAI permitirem o acesso a conhecimentos ou capacidades que anteriormente estavam vinculados a uma pessoa ou organização, disponibilizando uma combinação de elevada capacidade e elevada lealdade a um conjunto muito vasto de intervenientes. Hoje, com dinheiro suficiente, uma pessoa mal intencionada poderia contratar uma equipe de químicos para projetar e produzir novas armas químicas – mas não é tão fácil ter esse dinheiro ou encontrar/montar a equipe e convencê-los a fazer algo nada bonito. claramente ilegal, antiético e perigoso. Para evitar que os sistemas de IA desempenhem esse papel, melhorias nos métodos atuais podem ser suficientes,desde que todos esses sistemas e o acesso aos mesmos sejam geridos de forma responsável. Por outro lado, se sistemas poderosos forem lançados para uso geral e modificação, quaisquer medidas de segurança incorporadas serão provavelmente removíveis. Assim, para evitar riscos nesta classe, serão necessárias fortes restrições quanto ao que pode ser divulgado publicamente – análogas às restrições sobre detalhes de tecnologias nucleares, explosivas e outras tecnologias perigosas.

Uma segunda classe de riscos decorre da ampliação de máquinas que ao agir como ou se passar por pessoas. Esses riscos incluem golpes, spam e phishing muito mais eficazes. Muito mais importantes, porém, incluem a perturbação de processos sociais fundamentais, como a discussão e o debate públicos, os nossos sistemas sociais, processamento e disseminação de informações e conhecimentos, e os nossos sistemas de escolha política. A mitigação deste risco provavelmente envolverá (a) leis que restrinjam a personificação de pessoas por sistemas de IA como fraudulentas, (b) marcas d’água e sistemas de proveniência que identifiquem e classifiquem (de forma responsável) o conteúdo de IA gerado, e (c) novas tecnologias sociais. -sistemas epistêmicos técnicos que podem criar uma cadeia confiável de dados (por exemplo, câmeras e gravações) através de fatos, compreensão e bons modelos de mundo.

Tudo isso é possível, e a IA pode ajudar em algumas partes disso.

Um terceiro risco geral é que, na medida em que algumas tarefas são acopladas, os seres humanos que atualmente executam essas tarefas podem ter menos valor financeiro com o trabalho. Historicamente, a automatização de tarefas tornou as coisas possibilitadas por essas tarefas mais baratas e mais abundantes, ao mesmo tempo que classifica as pessoas que anteriormente executavam essas tarefas entre aquelas que ainda estão envolvidas na versão automatizada (geralmente com maior qualificação/remuneração) e aquelas cujo trabalho vale menos ou pouco. . Em termos gerais, é difícil prever em que setores será necessária mais ou menos mão-de-obra humana no setor resultante, maior mas mais eficiente. Paralelamente, a dinâmica da automação tende a aumentar a desigualdade e a produtividade geral, a diminuir o custo de certos bens e serviços (através de aumentos de eficiência) e a aumentar o custo de outros (através da doença dos custos). Para aqueles que estão do lado desfavorecido do aumento da desigualdade, não é profundamente claro se a diminuição dos custos de determinados bens e serviços compensa o aumento de outros e conduz a um maior bem-estar geral.

Então, como isso acontecerá para a IA?

Devido à relativa facilidade com que o trabalho intelectual humano pode ser substituído pelo GPAI, podemos esperar uma versão rápida disto com o GPAI humano-competitivo.Se fecharmos a porta ao SGPAI, pelo menos algumas pessoas continuarão a representar valores intelectuais valiosos. mão-de-obra (e o trabalho físico será automatizado muito mais lentamente), mas ainda é possível uma enorme deslocação da mão-de-obra ao longo de alguns anos. Para evitar o sofrimento económico generalizado, será provavelmente necessário implementar alguma forma de bens ou rendimentos básicos universais, e também arquitetar uma mudança cultural no sentido de valorizar e recompensar o trabalho centrado no ser humano que é mais difícil de automatizar (em vez de ver os preços do trabalho caírem). devido ao aumento da mão de obra disponível expulsa de outras partes da economia.) Outras construções, como a da “dignidade dos dados” (na qual os produtores humanos de dados de treinamento recebem royalties auto-atribuídos pelo valor criado por esses dados em IA) pode ajudar. A automação por GPAIs também tem um segundo efeito adverso potencial, que é a automação inadequada, ou seja, a substituição de humanos e a realização de um trabalho pior ou em aplicações onde os sistemas de IA são suscetíveis de violar preceitos morais, éticos ou legais. Estas podem incluir, por exemplo, a utilização de IA em decisões de vida e morte e em questões judiciais. Estas questões devem ser tratadas através da aplicação e do alargamento dos nossos atuais quadros jurídicos.

Finalmente, uma ameaça significativa do GPAI in-gate é o seu uso em persuasão, captura de atenção e manipulação. Temos visto nas redes sociais e noutras plataformas online o crescimento de uma economia da atenção profundamente enraizada (onde os serviços online lutam ferozmente pela atenção do utilizador) e de um sistema de “capitalismo de vigilância” (no qual a informação e o perfil do utilizador são adicionados à mercantilização da atenção). É quase certo que mais IA será colocada ao serviço de ambos. A IA já é muito usada em algoritmos de feed viciantes,

Mas isso evoluirá para um conteúdo viciante gerado por IA, personalizado para ser consumido compulsivamente por uma única pessoa. E as informações, respostas e dados dessa pessoa serão inseridos na máquina de atenção/publicidade para continuar o ciclo vicioso. Além disso, à medida que os agentes de IA fornecidos pelas empresas tecnológicas se tornam a interface para uma maior vida online, provavelmente substituirão os motores de pesquisa e os feeds como mecanismo através do qual ocorre a persuasão e a monetização dos clientes. O fracasso da nossa sociedade em controlar esta dinâmica até agora não é um bom presságio. Parte desta dinâmica pode ser atenuada através de regulamentações relativas à privacidade, direitos de dados e manipulação. Chegar mais à raiz do problema pode exigir perspectivas diferentes, como a da lealdade à IA: exigir um padrão de lealdade para com o utilizador (e não apenas para a empresa fornecedora de IA), ou criar assistentes de IA genuinamente leais que possam representar o interesses fiduciários de seus usuários e neutralizar o desequilíbrio de poder quando um usuário individual interage constantemente com um sistema corporativo/IA massivo.

O resultado desta discussão é o da esperança: sistemas in-Gate – pelo menos enquanto permanecerem comparáveis em potência e capacidade aos sistemas mais avançados de hoje – são provavelmente geríveis se houver vontade e coordenação para o fazer. Instituições humanas decentes, potencialmente capacitadas por ferramentas de IA, podem fazê-lo.

Existem duas maneiras pelas quais isso pode falhar.

Primeiro, poderíamos simplesmente não conseguir criar os mecanismos e instituições de governança necessários para gerir os sistemas in-Gate. Mas é difícil ver como permitir sistemas mais poderosos ajudaria (além de colocá-los no comando e esperar pelo melhor).

Em segundo lugar, pode acontecer que a IA in-Gate, quando desenvolvida e interligada o suficiente, já seja poderosa o suficiente para criar GPAI bastante sobre-humanos e muitos dos riscos que os acompanham.

Neste caso, o sistema resultante provavelmente será pelo menos muito mais gerenciável do que os sistemas monolíticos de redes neurais gigantes.Se a humanidade decidir que deseja manter o controle da IA, e isso exigir limites adicionais, pelo menos o fechamento do portão ajudaria. habilite isso.

Para evitar os riscos do GPAI e, ao mesmo tempo, colher os benefícios da IA na geração

Geralmente, existem várias formas de limites que se podem imaginar, por exemplo, que dependem das capacidades e/ou riscos dos sistemas; risco- limites baseados serão exigidos mesmo para sistemas não SGPAI. No entanto, limitar o SGPAI desta forma seria complexo em termos de definições, de definição e de implementação. Os limites de cálculo são, portanto, um primeiro e fundamental passo extremamente útil, por três razões principais.

Primeiro, a computação total de treinamento demonstrou ser um bom proxy para capacidade em sistemas GPAI. A maioria dos especialistas concorda que o grande progresso na IA foi possibilitado pela (e provavelmente resultou em grande parte) da aplicação de muito mais computação e dados a técnicas que existem há décadas. Há uma razão pela qual as empresas de IA estão comprando ou alugando um enorme número de GPUs de última geração. Em segundo lugar, a computação pode ser facilmente quantificada, contabilizada e auditada, com relativamente pouca ambiguidade, uma vez desenvolvidas boas regras para o fazer.

Terceiro, grandes quantidades de computação são, tal como o urânio enriquecido, um recurso muito escasso, caro e difícil de produzir. Embora os chips de computador sejam onipresentes, o hardware necessário para o SGPAI é caro e extremamente difícil de fabricar. Portanto, um passo relativamente simples, mas de enorme impacto seria um limite global para a quantidade total de computação, em yottaFLOP, que vai para uma rede neural, e um limite para os petaFLOP/s usados ao fazer inferência em uma determinada rede neural. Um limite de computação em redes neurais não será indefinidamente suficiente. para prevenir o SGPAI por si só: em princípio, o SGPAI poderia ser escrito inteiramente em código, sem rede neural. Provavelmente mais cedo, como discutido acima, redes neurais cuidadosamente elaboradas e conectadas corretamente poderiam criar SGPAI e, se mal arquitetadas, poderiam ter todos os riscos de uma rede neural gigante. E conforme discutido abaixo, com o passar do tempo, esses limites interfeririam mais em outros tipos de computação. Mas o precedente, os processos e os sistemas implementados para um limite computacional seriam inestimáveis na criação de um limite mais durável, caso decidíssemos estabelecer um.

Pode parecer que impor limites globais rígidos à IA exigiria enormes níveis de coordenação internacional e vigilância intrusiva e destruidora da privacidade. Felizmente, isso não aconteceria. O hardware que alimenta a IA avançada é altamente especializado e caro, e flui por uma cadeia de suprimentos muito restrita e com gargalos. Assim, uma vez estabelecido um limite legalmente (seja por lei ou ordem executiva), a verificação

A questão do cumprimento desse limite exigiria apenas envolvimento e cooperação de um punhado de grandes empresas. Com algumas exceções, o hardware especializado em IA representa uma parte relativamente pequena do modelo geral de negócios e receitas dessas empresas. Além disso, a lacuna entre o hardware usado em IA avançada e o hardware de “grau de consumo” é significativa, de modo que a maioria dos consumidores de hardware de computador não seria afetada em grande parte.Aqui está um exemplo de como um fechamento de portão poderia funcionar, dado um limite de N yottaFLOP para treinamento e M petaFLOP/s para inferência (executando a IA). Muitas variações são possíveis.

1. Pausa: por razões de segurança nacional, o Poder Executivo dos EUA pede a todas as empresas sediadas nos EUA, que fazem negócios nos EUA ou usam chips fabricados nos EUA, que parem e desistam indefinidamente de qualquer novo treinamento de IA que exceda o limite N yottaFLOP. (Mesmo que isso não seja exigido por força de lei.

Espera-se que a maioria, se não todas as empresas, cumpram, mesmo que se queixem.)

2. Supervisão e “desligamento” dos EUA: por ordem executiva ou ação de um agência reguladora existente, os EUA exigem que dentro de (digamos) um ano:

(a) Todas as execuções de treinamento de IA estimadas acima de N/100 yottaFLOP realizadas por empresas que operam nos EUA sejam registradas em um banco de dados mantido por uma agência reguladora dos EUA; esses registros incluiria detalhes da execução do treinamento, dados e ferramentas usadas, etc.

(b) Todo o hardware relevante para IA (GPU, TPU e computadores neuromórficos) fabricantes que operam nos EUA ou fazem negócios com o USG aderem a um conjunto de requisitos específicos hardware especializado e o software que o conduz. Entre eles está o requisito de que, se o hardware fizer parte de um sistema de alta velocidade, cluster interconectado capaz de executar M petaFLOP/s de computação, é necessário um nível mais alto de verificação. Inclui permissão regular de um “custodiante” remoto que recebe telemetria e solicitações para realizar cálculos adicionais, e concede permissão para fazer este cálculo.

(c) O custodiante (que também inclui o técnico de hardware do fabricante) relata o cálculo total realizado em seu hardware para a agência que mantém o banco de dados dos EUA; isso pode ser comparado ao registro para garantir que apenas registros de grande porte cálculos em escala estão ocorrendo.

(d) Requisitos mais fortes são escalonados para permitir ambos mais cura e supervisão e permissão mais flexíveis, bem esquemas de verificação para garantir que quando uma rede neural é feita a computação, as entradas e os métodos pelos quais ela foi calculado pode ser verificado.

3. Supervisão internacional: neste momento os EUA solicitaram, mas não impôs quaisquer limites de computação, mas criou a infra-estrutura para verificar o cumprimento dos limites. Isto pode então ser estendido internacionalmente.

(a) Os EUA, a China e quaisquer outros países que hospedem chips avançados com capacidade de produção, negociarão um acordo internacional.

(b) Este acordo cria uma nova agência da ONU encarregada de ver treinamento e execução de IA exatamente como a agência federal dos EUA na etapa 1.

(c) Os países signatários devem exigir que os seus fabricantes nacionais de hardware de IA cumpram um conjunto de requisitos pelo menos tão rigorosos como os impostos nos EUA, incluindo o registo de cálculos acima do limite N/100 yottaFLOP.

(d) Os custodiantes agora são obrigados a relatar números de cálculo de IA para ambas as agências nos seus países de origem, bem como para a agência da ONU.

(e) Outros países são fortemente encorajados a aderir ao acordo internacional existente: controlos de exportação por países signatários

Os laços restringem o acesso a hardware de última geração por não signatários, enquanto os signatários podem receber suporte técnico no gerenciamento seus sistemas de IA.

4. Monitoramento direto internacional, fechamento de portão e interruptor de desligamento:

(a) O sistema de verificação de hardware é atualizado para relatar o uso de computação tanto para o custodiante original quanto para um escritório na nova agência da ONU. Da mesma forma, permissão para executar blocos de cálculo deve ser obtido da agência (ou tanto da agência quanto do custodiante).

(b) A agência, por meio de discussão com os signatários do acordo internacional e nacional, concorda com limitações computacionais. Estes então assumem força legal nos países signatários. Verificação de adesão

A frequência pode ser verificada pela telemetria fornecida ao órgão e comparação com o cadastro. E se necessário, o limite pode ser aplicada recusando-se a conceder permissões a sistemas que solicitem mais do que a quantidade permitida de computação.

(c) Paralelamente, um conjunto de padrões internacionais pode ser desenvolvido

para que o treinamento e o funcionamento de IAs acima de um limite de putation (mas abaixo do limite) são obrigados a aderir a esses padrões. Estes seriam padrões mínimos, focados na segurança, complementado por regulamentação em jurisdições específicas, como a UE, a China e os EUA.

(d) A agência pode, se for considerado seguro e aconselhável (por exemplo, no nível de garantias de segurança comprováveis), aumentar o limite de cálculo.

No entanto, pode e deve manter a capacidade de monitorizar e, se necessário, encerrar sistemas avançados de IA.

Um plano como esse possui vários recursos altamente desejáveis. É minimamente invasivo no sentido de que apenas algumas grandes empresas têm exigências impostas a elas, e apenas clusters de computação bastante significativos seriam governados. Tanto a implementação como a aplicação dependem de restrições legais padrão. Mas estes são apoiados por termos de utilização do hardware e por controlos de hardware, simplificando enormemente a aplicação e prevenindo a fraude por parte de empresas, grupos privados ou mesmo países. Há um amplo precedente para empresas de hardware que impõem restrições remotas ao seu uso de hardware e bloqueiam/desbloqueiam recursos específicos externamente, inclusive até mesmo em CPUs de alta potência em data centers. Mesmo para a pequena fração de hardware e organizações afetadas, a supervisão seria limitada à telemetria, sem acesso direto aos dados ou aos próprios modelos;e o software para tal poderia estar aberto à inspeção para demonstrar que não estão a ser registados dados adicionais. O esquema é internacional e cooperativo, e bastante flexível e extensível.

Um fechamento de Gate baseado em computação também tem desvantagens.

Em primeiro lugar, está longe de ser uma solução completa para o problema da governaça da IA em geral. Em segundo lugar, à medida que o hardware do computador fica mais rápido, o sistema “capturaria” cada vez mais hardware em clusters cada vez menores (ou mesmo em GPUs individuais). Também é possível que, devido a melhorias algorítmicas, um limite de computação ainda menor seja necessário com o tempo. , ou que o valor da computação se torne em grande parte irrelevante e fechar o Portão exigiria, em vez disso, um regime de governação mais detalhado baseado no risco ou na capacidade para a IA. Terceiro, independentemente das garantias e do pequeno número de entidades afetadas, um tal sistema é obrigado a criar retrocessos em relação à privacidade e à vigilância, entre outras preocupações.

É claro que desenvolver e implementar um esquema de governaça num curto período de tempo será bastante desafiante e está fora da actual janela de discurso. Mas é absolutamente factível: está de acordo com o que o público realmente deseja, e as tecnologias de hardware e técnicas de software necessárias já existem (embora possam precisar de melhorias e maior segurança). O que poderia fornecer a vontade política necessária seria a compreensão generalizada (ou, muito pior, evidência) das terríveis consequências da alternativa.

A escolha diante de nós

A última vez que a humanidade partilhou a Terra com outras mentes que falavam, pensavam, construíam tecnologia e resolviam problemas de uso geral foi há 40 mil anos, na Europa da era glacial. Essas outras mentes foram extintas, provavelmente total ou em parte devido aos nossos esforços.

Estamos agora reentrando nesse momento.

Os produtos da nossa cultura e tecnologia – conjuntos de dados construídos a partir de toda a nossa informação comum na Internet e chips de 100 mil milhões de elementos que são as tecnologias mais complexas que alguma vez criámos – estão a ser combinados para criar sistemas avançados de IA de uso geral.

Os criadores destes sistemas estão interessados em retratá-los como ferramentas para a capacitação humana. E de fato eles poderiam ser. Mas não se engane: a nossa trajetória atual é construir agentes digitais cada vez mais poderosos, orientados para objetivos, tomadores de decisão e geralmente capazes. Eles já têm um desempenho tão bom quanto muitos humanos numa ampla gama de tarefas intelectuais, estão melhorando rapidamente e contribuindo para o seu próprio aperfeiçoamento.

A menos que esta trajetória mude ou encontre um obstáculo inesperado, em breve – dentro de anos, não décadas – teremos inteligências digitais perigosamente poderosas. Mesmo com os melhores resultados, estes trariam grandes benefícios econômicos (pelo menos para alguns de nós), mas à custa de uma profunda perturbação na nossa sociedade e da substituição dos seres humanos na maioria das coisas mais importantes que fazemos: estas máquinas pensam por nós, planejam para nós, decidem por nós e criam para nós. Seríamos mimados, como crianças mimadas. Muito mais provavelmente, estes sistemas substituiriam os seres humanos, tanto as coisas positivas como as negativas que fazemos, incluindo a exploração, a manipulação, a violência e a guerra.

Podemos sobreviver a versões hipercarregadas de IA ?

Finalmente, é mais do que plausível que as coisas não corressem nada bem: que relativamente em breve seríamos substituídos não apenas naquilo que fazemos, mas naquilo que somos, como arquitetos da civilização e do futuro.

Pergunte aos neandertais. Talvez também tenhamos fornecido a eles bugigangas extras por um tempo.

Não precisamos fazer isso. Temos IA competitiva entre humanos e não há necessidade de construir uma IA com a qual não possamos competir.

De forma alguma é inevitável.

Ao impor alguns limites rígidos e globais, podemos manter a capacidade geral da IA num nível aproximadamente humano, ao mesmo tempo que colhemos os benefícios da capacidade dos computadores para processar dados de formas produtivas, não podemos e automatizar tarefas que na verdade não queremos fazer. Estas ainda representariam muitos riscos, mas se forem bem concebidos e geridos, representarão um enorme benefício para a humanidade, desde a medicina à investigação e aos produtos de consumo. A imposição de limites exigiria cooperação internacional, mas menos do que se poderia pensar, e ainda deixariam muito espaço para uma enorme indústria de IA e de hardware de IA, focada em aplicações que melhoram o bem-estar humano, em vez da busca crua pelo poder. E se, com fortes garantias de segurança e após um diálogo global significativo, decidirmos ir mais longe, essa opção estará sempre aberta para nós.

A humanidade deveria optar por não desenvolver generalizações sobre-humanas de IA. Agora não, talvez nunca.

Artigo publico por Paulo Carvalho – CEO Xper

Leia mais em: https://www.xper.social/single-post/fechar-as-portas-para-um-futuro-desumano